- 생성 AI의 출발점이었던 LLM은 크게 파운데이션(foundation) 모델과 이를 미세 조정해 만든 파인튜닝 (fine-tuning) 모델로 나뉜다. 파운데이션 모델은 워낙 만들기가 어려워, 세계적으로도 그런 기술력을 지닌 업체가 손에 꼽을 정도다. 파운데이션 모델에서 미세조정을 거치면 여러 가지 파인튜닝 모델이 만들어지게 되는데, 그 쓰임새가 다양하다. 대표적인 파운데이션 모델로는 챗GPT 혁명을 주도한 장본인 오픈AI의 GPT 시리 즈, 구글의 제미나이, 메타의 라마, 알리바바의 큐원(通同; Qwen), 네이 버의 하이퍼클로바X 등을 예로 들 수 있다. 반면, 한국 AI 인프라 설루션 기업 모레가 개발해 최고의 성능을 인정받은 MoMo-70B는 알리바바의 큐원을 미세조정해 만든 파인튜닝 모델이고, 업스테이지의 '솔라' 같은 AI 모델도 같은 범주에 속한다.

- GPT-5, 스스로 진화하는 AI

지금 AI 업계는 GPT-5를 학수고대하고 있다. 매개변수가 GPT-4의 100배 이상인 125조개에 달한다는 소문까지 나도는 차세대 파운데이션 모델 GPT-5는 2024년 하반기 발표될 것으로 보인다. 일부 전문가들은 GPT-5가 추론 및 계획의 기능까지 갖춤으로써 인간 수준의 AGI에 도달 할 것이라고 평하기도 한다. 과연 스스로 진화해 인간의 지적 수준을 능 가할 만한 AI 모델인지, 궁금할 따름이다.

파운데이션 모델에 필요한 연산력은 3개월~4개월마다 두 배로 늘어 나고 있다. LLM인 Claude 2(클로드 2)와 LlaMa 2 (라마 2), 이미지 변환 모델인 Stable Diffusion (스테이블 디퓨전) 등 오늘날의 파운데이션 모델은 텍스트, 이미지, 대화, 코딩 등 다양한 작업을 수행한다.

전 세계에 챗GPT 열풍을 일으킨 오픈AI는 미상불 2023년 AI 생태 계의 최상위 포식자였다. 그들이 AI 시대의 개막을 선언했다고 해도 과 언이 아니다. 그리고 오픈AI의 승승장구는 곧 MS의 승리다. 일찌감치 오픈AI에 130억 달러라는 대규모 투자를 단행했고 그 결실을 함께 누 리고 있기 때문이다. MS는 오픈AI의 파운데이션 모델인 GPT 시리즈를 MS의 자체 서비스에 모두 적용하고 있다. 치열하게 전개 중인 AI 전쟁 의 초반엔 일단 MS-오픈AI가 승기를 잡은 모양새다. 다만 2024년 이후 에도 이런 독주가 이어질지는 모를 일이다. AI 비즈니스 모델이 워낙 다 양한 데다 고만고만한 AI 서비스가 우후죽순처럼 쏟아지고 있기 때문이 다. 구글과 손을 맞잡은 딥마인드도 주목의 대상이며, Anthropic(앤쓰로픽) 만 하더라도 언제든지 오픈AI 자리를 위협할 수 있다.

- 흥미롭게도 오픈AI의 동맹인 MS는 최근 오픈AI를 슬쩍 견제하는 모습이다. Phi-1.5(파이-1.5)라는 경량화 LLM을 공개하며 자체 AI 영역을 구축하려는 행보를 보인 것이다. 파이-1.5는 매개변수 13억 개에 불과하 지만, GPT에서 일차 가공해 생성한 합성데이터를 훈련했고 텍스트뿐만 아니라 이미지도 인식·해석할 수 있으며 누구나 무료로 쓸 수 있다. 업계 에선 MS가 자체 AI를 활용한 제품을 늘리고 개발자 생태계를 확장할 것 으로 예상한다.

- Gemini

챗GPT 혁명 1년 후 구글의 AI 전략은 'Gemini(제 미나이)' 생태계 확립이 뼈대를 이루는 것 같다. 생성 AI의 주도권을 앗아간 챗GPT로 인해 상처 입은 원조 AI 기업의 자존심 을 되찾겠다는 각오다. 급급히 AI 챗봇 Bard(바드)를 출시하고, 추론과 코 딩 능력을 강화한 PaLM2(팜2) 등 신형 LLM으로 반격했다. 인터넷 사용 률이 높고 구글 검색의 강력한 경쟁자가 있는 시장을 먼저 겨냥해 한국 어와 일어 서비스도 추가했다. 하지만 효과는 미미했다. 여전히 오픈AI 만 못하다는 세간의 평가에 와신상담 반격의 카드로 꺼낸 것이 제미나 이로, 범용 버전은 바드에 이미 적용됐다. 매개변수 크기에 따라 울트라· 프로·나노의 3개 모델로 나뉜다. 가령 최상위 모델 울트라는 매개변수가 1조 5,600억 개로, 현재 업계에서 가장 앞섰다는 오픈AI의 최상위 모델 GPT-4에 필적하는 수준이다.

- GPT-4 대항마로 출시한 제미나이는 새로운 범용 LLM인데, 설계 단 계부터 멀티모덜(multimodal; 복합정보처리) 기능을 지향한 첫 모델이다. 모바 일 기기부터 전문 데이터센터까지 모든 환경에서 텍스트, 이미지, 오디 오, 동영상, 코드 등 다양한 '모드'의 정보를 효율적으로 처리한다. 40개 이상의 언어 구사는 물론이고, 무엇보다 추론, 이해, 창작 능력을 갖추었 다는 게 가장 큰 특징이다. 이미지 인식의 수준을 넘어 대상의 속성과 특 징까지 파악·추론하고 수학 문제까지 척척 풀어낸다. 가령 사과와 쿠키 이미지를 보면 "쿠키보다는 사과가 건강에 더 좋다"는 판단까지 한다. 코 딩 성능도 훌륭해서 파이선, 자바, C++ 등의 프로그래밍 언어로 작성된 코드를 이해해 설명·생성한다. 코딩작업 성능을 평가하는 업계 표준 벤 치마크에서 GPT-4를 능가했다. 또 제미나이 최상위 모델 '울트라'는 대 규모 다중 작업 언어이해(MMLU) 능력 평가에서 GPT-4는 물론 인간 전문 가까지 뛰어넘는 정답률 90%를 기록했다.

- 구글은 일반 사용자에다 개발자까지 아우르는 제미나이 지원 체계 를 갖춰 챗GPT와 경쟁한다. 바드, 협업 소프트웨어 모음 Workspace(워크 스페이스), 클라우드 내 AI 협업 툴 Duet AI(듀엣 Al) 등을 위시한 모든 AI 서 비스 명칭을 제미나이로 통합해 제미나이 생태계를 확대한다는 계획이 다. 그렇게 된다면 AI 업계 선두를 쟁취할 수도 있을 것이다. 스마트폰에 서 쉽게 사용할 수 있는 제미나이 전용 애플리케이션도 출시했다. 제미 나이는 멀티모덜 AI의 성과와 안전성에 따라 제조와 IT는 물론이고 의 료, 교육 등 전 산업에 파급 효과를 미쳐 '생성 AI 2.0' 시대를 불러올 수 있다.

- 앞서 설명한 오픈AI의 파운데이션 모델 진화와 비슷하게, 메타 역시 '추론(reasoning)과 계획(planning)'을 수행할 수 있는 차세대 AI 모델 'Llama 3 (라마 3)' 출시를 예고 하고 나섰다. 메타의 첫 AI 모델 라마 1은 GPT-3 출시보다 무려 2년 8개 월가량 늦었지만, 메타가 부지런히 따라붙은 결과 라마 3은 GPT-5와 거 의 동시인 2024년 여름 세상에 나올 것으로 알려져 있다. 이렇듯 인간과 유사한 사고를 하도록 진화한 AI 모델은 조만간 현실이 될 전망이다. 지 금까지의 AI는 사전 학습한 데이터를 기반으로 최적의 답을 제시하지만, 앞으로는 미처 학습하지 않은 콘텐트에 관해서도 기존 데이터를 이용 한 추론을 통해 적합한 답을 내놓는다는 뜻이다. 다시 말해서, 이전에는 AI 모델의 개선이 데이터 학습량 및 속도의 증가로 이루어졌던 반면, 앞 으로는 성능이나 특성 자체에서 한 차원 높은 발전이 가능하리라는 얘기다.

기존의 AI 모델은 다분히 직선적이었다. 매개변수 규모로 측정되는 방대한 데이터를 학습하고, 그 범위 안에서만 프롬프트에 대한 답을 생 성했다. 학습하지 않은 사항에 대해선 '정보가 없어서 말할 수 없음'이라 고 답하거나, 아예 가짜 정보를 들이대는 ‘헐루시네이션(hallucination)' 현상 을 보였다. 하지만 추론 능력을 갖춘 AI라면 다르다. 설사 학습하지 못한 사항이라도 학습했던 데이터 속 유사한 내용을 '추론'해, 스스로 합리적 인 답변을 만들어낸다. 이처럼 상황을 판단하는 AI는 사안의 무게라든 지 우선순위도 계획할 수 있다. GPT-5와 라마 3부터는 다층적인 AI로 진화하는 셈이다. 인간의 능력과 다름없다. 요컨대 추론·계획의 능력은 바로 AI가 인간의 창의성, 상상력, 도덕관까지 따라 하게 만드는 결정적 인 변곡점이란 얘기다.

- 구글의 세 번째 칼

AI 스타트업 앤쓰로픽은 구글과 아마존이 AI의 꿈을 실현하기 위 해 손잡은 AI 모델 개발 스타트업이다. 그러니까 챗GPT의 대항마를 만 들어낼 만한 잠재력을 지닌 몇 안 되는 회사 중 하나다. '클로드'라는 이 름의 파운데이션 모델이 대표작이다. 그중 최신 '클로드 3' 모델은 대학

원 수준의 추론과 기초 수학 등 능력 검증에서 GPT-4를 능가한다는 평 가다.

- 아마존과 구글이 앤쓰로픽에 거금을 쏟아붓고 자신들의 클라우드 서비스를 통해 앤쓰로픽의 AI 모델을 판매하는 등, 밀월 관계를 만들고 있는 이유는 무엇일까. 가장 큰 이유는 MS-오픈AI의 성공적인 동맹에 맞설 강력한 파트너십이 필요하기 때문이다. 챗GPT 혁명의 주도권을 놓 치고 후발주자가 돼버린 아마존과 구글이 앤쓰로픽을 그 대안으로 선택 한 것이다. 덕분에 앤쓰로픽의 기업가치는 1년도 안 되는 기간에 4.5배로 폭등해 190억 달러 정도로 평가받고 있다. 오픈AI의 초기 몸값 폭등을 연상케 한다.

- 최근 챗GPT는 주춤하고 있다. 2023년 말 기준 글로벌 트래픽이 9.7% 하락했다는 조사 결과도 있다. GPT-4를 적용한 MS의 검색엔진 'Bing(빙)'은 구글의 압도적 (92%)인 점유율에 흠집조차 내지 못하고 있다. 앤쓰로픽의 클로드 3까지 등장하면서, 결국 생성 AI 기술을 둘러싼 MS 와 구글의 대리전이 벌어진 양상이다. AI 업계에서 소위 '1군 기업'으로 분류되는 앤쓰로픽은 향후 12개 이상의 주요 산업에 진출할 계획이라고 한다. 업계는 클로드 3을 가리켜 '구글의 세 번째 칼'이라 평가한다. 클로 드 AI 모델을 활용한 다양한 서비스를 통해 구글의 AI 경쟁력이 한층 강 화될 수 있을까.

- 챗봇은 다재다능하다. 그렇다고 그 많은 기능을 고객이 다 필요로 하는 건 아니다. 업무시간을 단축해주는 LLM 기반의 AI 챗봇에 대한 기 업 수요는 빠르게 늘고 있지만, 기업의 정보를 학습시키고 내부 정보에 특화한 앱으로 만들기까지는 많은 시간과 노력이 들어간다. 국내 AI 플 랫폼 스타트업 올거나이즈는 고객사 특성에 맞춘 언어모델, 챗봇, 앱까 지 한 번에 제공하는 올-인-원 설루션 알리 앤서(Alli Answer)'를 개발했다. 이 복잡다단한 과정을 쉽게 진행하도록 돕는 '해결사'다. 고객사는 챗 GPT, 제미나이, 클로바X 등 15종의 LLM을 원하는 대로 활용해 자신에 게 적합한 '알리 앤서'를 만들 수 있다. 올거나이즈는 또 자신들이 직접 개발한 SLLM을 공급하기도 한다. 금융 분야에 특화된 '알리 파이낸스' 같은 경량 AI 모델이 그런 예에 속한다.

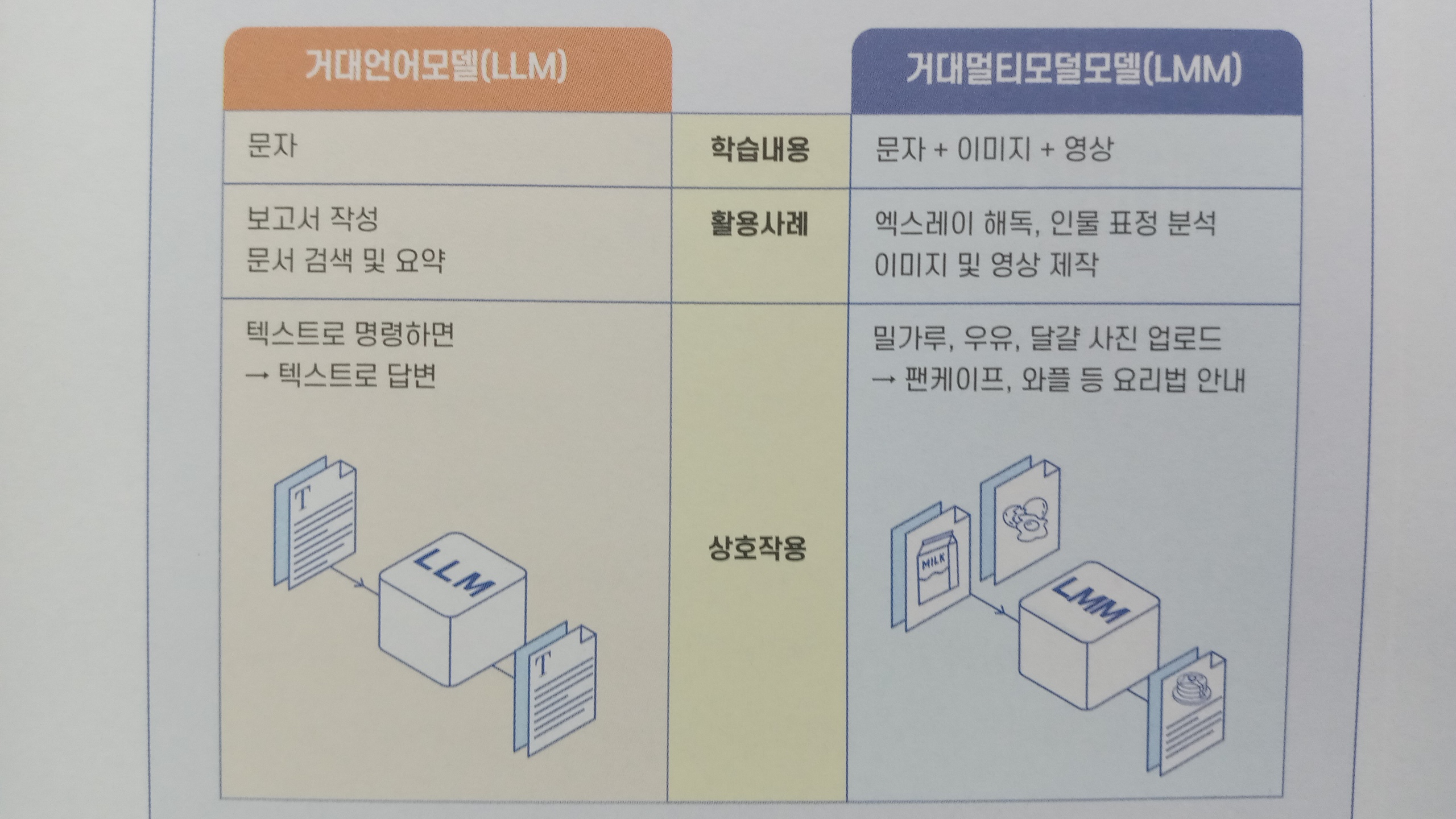

- GPT-4V 같은 LMM의 가장 큰 특징은 무엇일까? 텍스트와 이미지 사이의 경계가 없어진 것이다. 이전의 GPT-3 혹은 4에서 텍스트 프롬프 트를 사용하는 것처럼, 사진, 그래프, 도형, 표, 사진 속 언어 등의 이미지 로 명령해도 쉽게 상호 작용한다는 뜻이다. 예를 들어 사람의 여러 가지 표정을 이미지로 보여주면 화남, 놀람, 기쁨 등의 감정을 구분해낸다. 엑 스레이 사진을 보여주면, 이를 해독해 어디에 골절이 생겼는지 또는 무 슨 질병인지를 가려낸다. 또 소고기뭇국 만드는 과정의 사진 몇 장을 뒤 죽박죽 보여주고(텍스트 대신 이미지로 프롬프트하고) 조리법을 순서대로 정렬하 라고 명령하면 정확하게 답을 내놓는다. 여러 가지 '모드'로 인간과 상호 작용하는 AI라는 얘기다.

- 물론 예전에도 멀티모덜 개념은 있었다. 다만 완성도 높은 멀티모덜 AI 모델이 나오기까진 상당한 시간이 필요할 것으로 보였다. 이미지나 다른 '모드'는 텍스트보다 인식이 복잡하고, 방대한 데이터로 학습·훈련 해야 하기 때문이다. 그러나 개발자들은 기존의 LLM에다 소프트웨어 를 붙임으로써 이미지 정보를 이해하는 구조를 버리고, 이미지 등 다른 '모드'의 정보를 이해하는 LMM 코어를 새로이 개발했다. 그 결과 인식 률과 속도 등에서 현저한 개선을 이룰 수 있었다. 아예 'LMM'이란 새이 름을 붙여 기존의 LLM 모델과 구분하게 된 것도 그래서다.

생성 AI가 품고 있는 여러 가능성이 검증되면서, 2024년은 AI 서비 스가 더욱 확산하는 해, 특히 LLM 중심이라기보다 멀티모델에 더욱 주 목하는 해가 될 것으로 보인다. 나아가 멀티모덜 AI가 AI 시뮬레이션과 어우러지면 환경·공간 데이터나 3D 객체를 생성할 수 있게 되어, 디지털트윈, VR, AR 같은 복잡한 시스템을 시뮬레이션할 수도 있다.

- 텍스트 프롬프트에 맞춰 동영상을 만들어주는 오픈AI의 AI 모델 'Sora(소라)'는 아닌 게 아니라 보는 이의 입을 떡 벌어지게 만든다. 언어에 대한 깊은 이해로 프롬프트를 정확히 해석하는 건 기본이다. 매력적이고 감정이 생생한 캐릭터까지 생성한다. 특정한 동작 혹은 복잡한 장면까지 이해하고 만들어낸다. 아직은 최대 1분 길이의 동영상을 만들지만, 프롬 프트 자체를 인식할 뿐만 아니라 그 프롬프트 내용이 물리적 세계에 어 떻게 존재하는지를 이해한다는 게 놀라울 따름이다. 텍스트가 아닌 이 미지를 프롬프트로 입력해도 동영상을 생성하고, 기존 동영상을 확장하 거나 누락된 프레임을 채우기까지 한다.

물론 구글이나 메타와 Runway AI(런웨이 AI) 같은 스타트업들도 '텍스 트 투 비디오 모델을 개발한 바 있다. 그렇지만 오픈AI의 소라를 두고는 다른 유사 모델보다 비주얼 품질이 좋고 생성물이 사용자의 요구에 훨씬 충실하다는 평이다. 소라는 파라마운트와 워너브러더스 등 할리우드 주 요제작자 경영진에도 이미 소개되었다고 하니, 영화산업이 이를 활용할 가능성도 열려 있다.

- 가우스는 이후 출시된 스마트폰 갤럭시S24 시리즈에 온디바이스 AI형태로 장착되었다. 개인정보 전송 없이도 편리한 자체 검색, 스마트폰 제어, AI 코딩, 문장 요약, 문법 교정, 실시간 번역, 문자로 묘사한 사물의 이미지 생성 등 편리한 기능들이 모두 삼성 가우스로 인해 가능해졌다. 2024년을 시작으로 모든 가전제품에 온디바이스 AI를 적용하겠다고 선 언했던 삼성전자는 이 생성 AI 모델을 통해 모바일·가전 등 사업 경쟁력 을 배가시킬 온디바이스 AI 시대를 열고자 한다. 그야말로 인공지능이 '내 손안으로 들어오는 시대를 앞당길 것이다.

- 온디바이스 AI의 활황은 메모리 반도체 시장에도 호재여서, 삼성전자와 퀄컴 등 반도체 업계는 이를 뒷받침하기 위한 칩 개발에 분주하다. 온디바이스 AI가 탑재된 기기는 클라우드와 연결되지 않은 채 스스로 연산·추론을 해야 하므로, 내부에 상당한 데이터를 축적·보관해야 한다. 고로 엄청난 양의 고성능·고용량 낸드플래시와 D램이 거기 들어가지 않 겠는가. 저전력 D램이라든지 저지연(low latency) D램 같은 특별한 메모리 칩의 수요도 그래서 늘어나고, 스마트폰의 두뇌 역할을 하는 핵심 칩인 모바일 AP 개발에도 속도가 붙었다. 나아가 시스템반도체 역시 보기 드 문 팽창을 누릴 수 있다. 반도체 평균 가격이 온디바이스 생성 AI 덕분에 당분간 연 10%씩 오를 거란 예측도 나온다.

- AIPC 생태계 조성

2023년 NPU까지 내장한 AI 전용 PC 칩 Core Ultra(코어 울트라)를 출 시하면서 'AI PC 가속화' 전략을 뽑아 든 인텔은 자사 AI 반도체를 앞세 워 AI PC 생태계 조성에 한창이다. AI PC에 들어가는 칩은 기존의 CPU,

- GPU와 함께 AI 추론·연산에 특화된 NPU가 탑재되어 있다는 게 특징이 다. 인터넷 연결 없이 PC가 자체적으로 연산을 처리하려면 NPU는 필수 다. 인텔은 또 300개가 넘는 AI 기능을 AI PC에 추가하고자 한다. 이를 위해 2024년 말경 데이터가 생성·사용되는 기기 자체에서 AI 기능을 활 용하도록, PC 플랫폼 'Lunar Lake(루나 레이크)'와 'Arrow Lake(애로우 레이크)' 를 내놓는다. 2025년까지 인텔 기반 AI PC를 1억 대 이상 공급하도록 소 프트웨어 하드웨어 생태계를 강화하며, 개인 혹은 소규모 개발자도 쉽 게 AI 기술을 구현하도록 지원할 계획이다.

- 퀄컴의 Snapdragon X Elite(스냅드래건 X 엘리트)는 AI에 활용하기 위해 특 별히 설계된 기능을 품고 있다. 130억 개 이상의 매개변수를 사용하는 생성 AI를 실행할 수 있으며, AI 처리 능력에서 경쟁사보다 4.5배 빠르면 서도 전력 소비는 68%나 줄었다고 해서 업계의 주목을 받았다. 퀄컴의 자랑처럼 모바일 컴퓨팅 분야에서 새로운 CPU 리더가 될지, 두고 볼 일 이다.

맥북에 들어가는 PC용 칩들은 애플이 설계해 TSMC의 3나노 공정 으로 제조하는데, AI 머신 러닝 기능을 강화했다는 점이 특별하다. 한편 HP는 인텔의 미티어 레이크 출시에 맞춰 신제품을 내놓았는데, LG전자 와 HP가 이를 활용한 AI 노트북을 준비하고 있다.

- 점차 커지는 오픈소스 진영

LLM 등 근원 AI 기술에서 뒤진 국내 업체들도 개방형 AI 분야에서 는 두각을 나타내고 있다. 카카오는 자체 LLM인 '코GPT 2.0'의 출시를 미루며, 범용의 중형 LLM 대신 산업 영역별로 특화한 경량 LLM 위주로 생성 AI 서비스를 내놓는 안을 고려하고 있다. 또 '허니비'라는 멀티모덜 LLM을 스스로 개발해 개방형 AI 플랫폼 '깃허브'에 선보인 카카오브레 인은 오픈소스로 이 기술을 풀어 생성 AI 생태계를 효율적으로 구축할 예정이다. 허니비를 활용해 좀 더 많은 기업이 각종 서비스를 내놓을 수 있도록 하겠다는 전략이다. AI 모델인 '엑사원 2.0'을 통해 멀티모덜 AI 기술을 공개한 LG AI 연구원도 AWS 플랫폼에서 이 기술을 오픈소스로 풀어 해외 시장을 공략하겠다는 구상이다.

- 국내 AI 스타트업의 오픈소스 약진도 두드러진다. 업스테이지는 자체 개발한 매개변수 107억 개의 AI 모델 '솔라'가 공개 직후 허깅 페이스 AI 성능 순위에서 1위를 차지해 눈길을 끌었다. 모레가 개발한 매개변수 700억 개의 'MoMo-70B' 역시 AI 모델의 성능을 평가하는 허깅 페이스 의 오픈 LLM 리더보드 평가에서 세계 1위를 차지했다. AI 에듀테크 스 타트업 뤼이드와 카카오뱅크의 LLM '카본빌런'까지, 'AI의 빌보드 차트' 로 불리는 허깅 페이스 경쟁에서 국내 업체가 1위 자리를 거머쥔 게 벌써 네 번째다. 오픈소스 진영의 확대는 국내 소규모 스타트업들이 기술력을 뽐낼 기회로 인식되며, 전체적으로 AI 시장 내 개방형 모델의 점유율은 앞으로도 계속 높아질 전망이다.

- 챗GPT 열풍 직후 중국 최초의 AI 챗봇을 만든 것도 바이두였다. 한 때 '짝퉁 구글'이란 오명에 시달렸지만, 자체 개발 LLM을 기반으로 '어 니봇(心一言; Ernie Bot)'이라 불리는 이 챗봇은 출시 13개월 만에 2억 명이 넘는 사용자를 확보했다. 삼성 갤럭시S24 시리즈와 애플의 중국 판매용 아이폰을 위시해 글로벌 스마트폰들도 중국 출시를 위해선 어니봇을 내 장한다. 텐센트의 위챗처럼 어니도 머지않아 중국 14억 인구가 쓰게 될 것이란 예상 때문이다.

바이두의 AI 개발 역사는 10년이 넘는다. 이미 2013년에 딥 러닝 연 구조직을 갖추었고, 이듬해 'AI 4대 천왕'인 앤드루 응 스탠퍼드 교수를 영입하며 실리콘 밸리에 연구소를 세웠다. 지금도 바이두는 실리콘 밸리 와의 격차를 좁히기 위해 AI 인재 확보에 목숨을 건다. 최대 5,000만 위 안(96억원)의 상금이 걸린 '어니 창업 경진대회'를 열어 개발자·창업자 를 끌어모으는 동시에 바이두의 AI 툴 활용도 독려한다. 바이두의 2023 년 R&D 투자는 매출의 18%인 241억9,200만 위안으로, 연간 순이익과 맞먹는다. 최근 10년간 R&D 누적 투자액만 1,700억 위안(약 32조4,000억 원) 에 달하는 글로벌 IT 기업으로 성장했다. 바이두는 AI와 자율주행차의 생성 AI 작동의 기반인 '파운데이션 모델'을 개발한 한국 기업이 2023년 한 곳도 없었다. 가장 많이 개발한 국가는 미국으로 109개를 만 들었다. 2위는 20개를 개발한 중국, 그리고 영국(8), UAE(4) 등이 그 뒤를 이었다. 한국보다 GDP 규모가 작은 나라들도 파운데이션 모델 개발에 성공했다. 알다시피 챗GPT나 미드저니 등은 모두 파운데이션 모델을 기반으로 개발됐다. 국내 업체들도 글로벌 AI 경쟁에 뛰어들었지만, 기 반 기술은 해외에서 그대로 들여온 경우가 대부분이다. 한국에는 쓸만 한 LLM이 없는 데다, 해외 LLM도 한국어를 꽤 잘 처리하기 때문이다. 해외에서 핵심 AI 기술을 도입하는 기업은 많고, 고객을 만족시킬 AI 서 비스를 내놓는 기술은 부족하다. 우리의 IT 생태계가 해외 빅 테크에 종 속될 것이라는 우려의 목소리가 나오는 이유다.

- 저커버그는 AGI 구축이 메타의 장기 비전이라고 했다. 하지만 어느 정도의 '장기'를 의미하는 걸까? AI 권위자들은 대체로 AGI 개발에 30 년 이상이 필요하다고 예측한다. 그런가 하면, 젠슨 황은 5년 후면 AGI 수준에 도달할 '인간의 모든 시험을 통과할 것으로 보고, 일론 머스크는 3년 이내로 예측한다. 손정의 소프트뱅크 회장은 아예 2028년이라고 시점을 특정한다. 오픈AI 역시 AGI 완성에 4년~5년이면 충분하다고 말한다. 자 신들의 초고화질의 동영상 생성 시스템 '소라'를 보면 그럴 가능성이 크 다는 논리다. 또 오픈AI가 AI 기술을 개발하는 과정에서 'QQ스타'라는 모델이 나왔다고 하는데, 일각에선 이 Q스타가 AGI 탐색의 돌파구일지 모른다는 이야기도 있다. 이런저런 전망을 종합해보면, 현재의 혁신 속 도를 고려할 때 지금부터 10년 안에는 AGI로 나아가는 진전이 상당히 이뤄질 것 같다.

- AI가 인간 수준에 도달하려면 훨씬 더 오랜 시간이 필요하다는 반 론도 만만치 않다. 가령 '인공지능 4대 구루'로 꼽히는 Yann LeCun(얀르 쿤)은 AGI 단계에 도달하려면 3년~5년 정도로는 어림없다고 말한 바 있 다. 왜 그럴까? 바둑이나 체스를 두어서 인간을 이긴다든지, 변호사 시 험에 너끈히 합격한다는 점에서는 AI가 제법 그럴싸하지만, 인간 수준 의 인식·판단·예측·상상에는 훨씬 미치지 못한다는 이유에서다. 10대 젊 은이에게 자동차 운전을 가르치는 데 20시간이면 충분하지만, AGI 수준 에 이른 인공지능이라도 20시간의 학습으로 운전할 수 있겠는가. 그래서 그는 AI를 살인 로봇이니 핵무기에 비유하다니, '걱정도 팔자'라고 일갈 했다.

- FAANG도 M7도 옛날얘기, 이젠 A15 시대

'FAANG' 이란 표현이 등장한 건 2013년 경제방송 CNBC를 통해서였다. 페이스북·애플·아마존·넷플릭스·구글을 지칭하는 용어로 당시 세계 경제와 미 국 증시를 주도하는 거인들을 망라했다. 2023년에 쓰이기 시작한 'M7'은 '굉 장한'이라는 뜻의 매그니피슨트(Magnificent) 첫 글자와 구글·애플·메타·아마존· 엔비디아·테슬라·마이크로소프트를 아우르는 7종목의 조합이다. 뱅크 오브 아메리카가 빚어낸 이름이다.

이제 FAANG도 M7도 빛바랜 용어가 될 것 같다. 엔비디아·MS·AMD·TSMC· 브로드컴을 가리키는 'A15'가 주목받고 있으니까. 미국 금융투자사 Light Street Capital (라이트 스트리트 캐피털)이 쓰기 시작했다고 한다. 다소 생소한 새 얼굴도 들어 있는 데다, 대만의 TSMC가 끼어 있어 눈길을 끈다. 아마도 AI 반 도체를 포함해 세계 반도체의 절반 이상을 만들어내는 파운드리 생산력을 인 정받았기 때문이리라. 최근엔 A15 외에 'MM'라는 신조어도 가끔 눈에 띈다. M7 가운데 AI 시대에 들어서도 반짝반짝 빛을 내는 MS·엔비디아·메타 3종목 을 가리키는 이름이다.

- AI 반도체가 구성되는 단계를 아래와 같이 생각해보면 쉬울 것이다.

1) D램(메모리)

2) HBM = D램을 여러 개 쌓아 만든 고성능 메모리

3) AI 가속기 = HBM 여러 개와 GPU를 조합해서 만든 장치

4) AI 컴퓨터 = AI 가속기+ CPU+ 낸드플래시 (대규모 메모리) 결합

5) AI 데이터센터 = AI 컴퓨터를 수천 대 모아서 만든 데이터센터

*엔비디아 발전

- 1차 도약

엔비디아는 챗GPT 혁명과 더불어 최고 성능의 AI 반도체인 H100과 AI 학습 모델에 특화한 GPU인 A100을 출시하면서 본격적인 비상을 시 작한다. 어마어마한 고속 병렬 계산으로 복잡한 3차원 이미지를 자연스 레 구현한 엔비디아의 GPU는 이후 빠르게 생성 AI 반도체 시대의 주인 공이 돼, 불과 몇 달 만에 AI 가속기 시장을 점령하다시피 (90% 이상 점유율 확보) 했다. 이들은 빅 테크의 AI 서비스뿐만 아니라 각국 정부의 데이터 센터 및 수퍼컴퓨터 구축에도 필수품이 되어 지금도 품귀 상태다. LLM 개발에 쓰이며 개당 가격이 6,000만 원까지 치솟은 H100은 성능도 단연 우수하고 함께 제공되는 소프트웨어 서비스까지 압도적이어서, 타사의 경쟁을 허락하지 않는 독보적 제품이다.

- 2차 도약

2023년에 공개했던 Grace Hopper(그레이스 호퍼)라는 이름의 인공지능 수퍼칩 'GH200'가 2024년 2분기부터 양산에 들어가면서 엔비디아는 AI 반도체의 왕좌를 한층 더 굳건히 다진다. H100만 해도 현존 최고 사양을 자랑하는데, 그 성능을 다시 혁신적으로 끌어올린 엔비디아의 차세 대 AI 반도체가 바로 GH200이다. 게다가 GH200에 탑재된 CPU와 핵심 메모리인 HBM3E(5세대 HBM)까지도 엔비디아가 직접 설계했다고 하니, 놀라울 따름이다. 머잖아 대형 AI 플랫폼 기업들은 개당 1억 원의 가격 표가 붙은 GH200을 사기 위해 긴 줄을 서야 할 것 같다. 그런 기업 하나 마다 100만 개의 GH200이 필요할 거라는 가정은 그리 비현실적이지 않 다. 그런 기업이 10개만 된다고 해도 엔비디아 매출은 1,000조 원에 이른 다는 계산이 나온다. 그런 기업이 100개라면 매출은 현기증이 날 정도다. 시가총액 2,672조 원으로 세계 3위(2024년 3월 1일 기준)에 등극한 엔비디아 의 성장이 어디까지일지는 예측 불허다.

- 3차 도약

2024년 3월 연례 GTC에서 젠슨 황은 엔비디아의 '초격차'를 재확인 할 또 한 번의 AI 반도체 충격을 선사한다. 그가 '컴퓨팅의 새로운 시대 를 열게 될 최강 칩'이라 소개한 차세대 AI 반도체는 'Blackwell(블랙웰)’. 전작 그레이스 호퍼와 견주어도 블랙웰 GPU의 연산 속도는 2.5배 빨라 졌고, 블랙웰 기반 시스템으로 AI가 학습하거나 추론하면 최대 30배의 성능을 낸다. H200은 현재 가장 앞섰다는 GPU인데, 이를 넘어선다면 '괴물'의 탄생이라 불러도 좋겠다. 황의 말마따나, 물리학의 한계를 넘어 칩이 얼마나 확장될 수 있는지를 보여준다.

블랙웰 GPU의 기본 모델인 'B100'에는 트랜지스터가 2,080 억 개나 들어있어, H100의 800억 개를 압도한다. 칩 내부의 두 GPU를 연결해 하 나의 거대한 칩으로 작동하게 만듦으로써 트랜지스터 집적의 한계를 뛰어넘었다. 이걸 뒤집어 말하자면, H100을 활용해 GPT를 훈련하면 GPU가 8,000개 필요하지만, B100을 쓸 땐 2,000개만 있어도 같은 결과를 낸 다는 얘기다. 블랙웰은 2024년 말부터 판매될 것으로 알려져, 업계가 온 통 주목하고 있다.

- 물론 엔비디아의 앞에 꽃길만 있는 건 아니다. 무엇보다 AMD, 인텔, 구글, 메타 등이 AI 반도체를 자체 개발하며 무섭게 추격 중이다. 지금 이야 엔비디아가 정하는 가격조차 아무도 이의를 달지 못할 정도로 '엔 비디아 천하지만, 2년~3년 지나면 어떤 경쟁 구도가 될지 예측 불가능이 다. 게다가 AI 모델과 기술 자체가 아직 초기 단계인지라, 앞으로 5년~10 년 후의 AI 생태계가 어떤 하드웨어를 요구할지 누구도 자신 있게 말할 수 없다. AI를 통한 사업 확장을 이룩하려면 상상을 뛰어넘는 자본을 투 입해야 한다는 것도 작지 않은 걸림돌이다.

- 이젠 반도체회사 아니고, AI 인프라 업체

이런 상황을 모를 리가 없는 엔비디아는 이미 단순한 반도체 기업 이 아닌 AI 인프라 업체 혹은 '종합 AI 플랫폼 기업'으로 진화하고 있다. GPU 기술 고도화와 AI 산업 수직계열화로써 시너지 효과를 극대화하 고, 너른 생태계를 구축해 종합 AI 설루션 기업으로 나아가자는 전략이 다. 자신들의 GPU 기반으로 소규모 AI를 개발하고 배포하는 'NIM'이란 서비스가 좋은 예다. 막대한 예산, 별도 서버 구축, 외부 클라우드 활용 등이 부담스러운 기업들이 엔비디아의 수퍼컴퓨터를 필요한 만큼 써서 LLM을 훈련하고 생성 AI 앱을 개발하도록 하는 '엔비디아 DGX 클라우 드'도 마찬가지다.

- 엔비디아는 AI 수퍼컴퓨터 분야에서도 빼어난 실력자다. 생성 AI를 수백만 명에게 실시간으로 서비스하려면, 가령 챗GPT GPT-3.5의 경우 1만 개의 GPU가 필요했다. (GPU 하나로만 LLM을 학습시킨다면 수백 년이 걸릴 터!) 그러나 GPU 개수를 늘릴수록 학습 시간은 획기적으로 줄어든다. 광통 신으로 서로 연결된 수백~수만 개의 GPU를 장착한 초거대 AI 연산 기 기를 'AI Supercomputer(AI 수퍼컴퓨터)'라고 부른다. 2023년 발표한 AI 수퍼 컴퓨터 DGX GH200'에는 위에서 이미 설명한 GH200을 256개 연결해 탑재했다. 현재 전 세계 탑텐 AI 수퍼컴퓨터 가운데 일곱 개가 엔비디아 의 GPU 및 수퍼컴퓨터 설루션 'CUDA(다)'를 쓰고 있다. AI 수퍼컴퓨 터 역시 엔비디아의 비장의 무기인 셈이다.

이게 전부가 아니다. 엔비디아는 직접 AI 모델도 개발하는 등, 아 예 AI 생태계를 스스로 구축하려는 중이다. 북치고 장구까지 치는 모습이랄까. AI 서비스 개발에 필수인 하드웨어와 소프트웨어 기술을 깡 그리 장악한 기업의 막대한 영향력이 다시금 느껴진다. 더욱 놀라운 건 'BioNeMo (바이오니모)'라는 AI 신약 개발 플랫폼까지 개발했다는 사실이 다. 바이오 및 신약 개발 분야에 맞게 확장된 AI 서비스를 제공해 AI 생 명공학 혁신에 도전할 정도이니, 게임용 GPU를 만들어 팔던 그 엔비디 아가 맞는가, 의아할 정도다. 질병이나 치료 분야에 특화된 신약을 개발 해내는 전혀 다른 모습의 엔비디아, 이것이 바로 AI의 힘이다.

- 인텔, 탈엔비디아의 선봉장

엔비디아 추격의 고삐를 제대로 당긴 것은 '잠든 사자' 인텔이라고 봐야겠다. 2024년 4월 최신 AI 반도체 'Gaudi 3(가우디 3)'를 최초로 공개하 면서 '탈엔비디아 연합전선'을 선언했기 때문이다. 엔비디아의 AI 개발 플랫폼 CUDA (쿠다)와 AI 가속기를 쓰지 않고서도 대등한 수준의 AI를 개발할 수 있는 동맹 체제를 구축하겠다는 전략이다. AI 반도체 시장의 급성장을 부활의 계기로 삼은 인텔의 야심작 가우디 3의 특성은 다음과 같이 요약된다.

- 특히 인텔은 또 한 번 세상을 바꿀 가우디 프로젝트의 가장 핵심적인 파트너로 네이버를 지목해 업계를 놀라게 했다. 자사 클라우드 인프라에 가우디 2를 이미 도입한 네이버는 가우디 소프트웨어 생태계 확장을 위해 인텔과 공동 연구소를 만들고 다양한 고객사에 가우디를 기반 으로 한 AI 딥 러닝 서비스를 제공할 계획이다.

길게 보면 30년간 견고하게 구축해온 엔비디아의 AI 반도체 생태계 를 과연 허물어뜨릴 수 있을까. 더구나 오픈AI, 구글, 애플 등도 자체 AI 모델을 위한 맞춤형 반도체 개발에 사활을 걸고 있지 않은가. 또 엔비디 아의 AI 반도체는 이미 2나노 공정으로 만들어지고 있지 않은가. 그렇다, 인텔로서도 우선 시장을 선별적으로 공략했다가 점차 시장을 확대하는 등의 전략을 구사하겠지만, 엔비디아의 아성을 단기간에 따라잡기는 쉽 지 않을 것이다. 그럼에도, 이제 초기에 불과한 AI 반도체 시장은 인텔이 오래 장악했던 CPU 시장과 사뭇 달라서 엔비디아의 독점 지속이 쉽지 않다는 게 업계의 의견이다. AI 반도체 개발·검증, 고객사 확보 등에 필 요한 비용과 시간을 감당할 수만 있다면 엔비디아 독점 시대를 무너뜨 릴 수 있다는 얘기다.

- 끈질긴 경쟁자 AMD

엔비디아의 또 다른 강력한 경쟁사는 AMD다. 고성능 AI 칩 'MI300X'와 가속 처리장치인 'MI300A'로 구성된 MI300 시리즈로 2024 년 들어 주문 규모가 두 달 만에 35억 달러(4조6,095억 원)를 넘어섰다. 특히 MI300X는 H100 라인업보다 메모리 용량이 2.4배, 대역폭이 1.6배 이상 이라고 평가된다. AMD는 CPU와 GPU를 협업하게 만들어 컴퓨팅 성능 을 끌어올리는 소위 '이기종 컴퓨팅'을 개발해왔고, 현재 이 기술은 클라우드와 고객 컴퓨팅 환경 등 많은 분야에서 주류가 되어 있다. 또 예전에 사용되던 단일 칩의 성능 한계 및 높은 비용을 극복하기 위해 '3D chiplet (3차원 칩렛)'이라는 칩 설계 방식을 적극적으로 활용하고 있다.

추가로 2024년 말에 2년 전 출시했던 AI 가속기의 3세대 제품을 출 시할 예정인 AMD는 전반적으로 AI 가속을 지원하는 소프트웨어와 앱 등도 내놓고 있다. GPU 프로그래밍을 위한 자체 소프트웨어 플랫폼인 'ROCm'은 주요 AI 프레임워크와의 탁월한 호환성을 자랑하면서 엔비 디아의 쿠다와 직접 맞붙어서 경쟁하고 있다. 그 결과 AMD는 클라우드 컴퓨팅에서부터 의료영상, 수퍼컴퓨터, 로봇 수술, 심지어 PC와 게임 콘 솔에 이르기까지 전 분야를 지원하고 있다. 삼성전자와도 손잡고 차세대 SoC(System on a Chip; 시스템온칩) 설계자산(IP) 최적화를 도모하고 있다.

- 삼성전자, 엔비디아의 뒤통수를 때릴지도

엔비디아의 AI 칩은 막대한 전기를 필요로 한다. 그들의 GPU가 업 그레이드됨에 따라 최대 소비전력도 400W→ 700W→ 1,000W(B100)로 급 등해, 개당 대형 에어컨에 버금가는 전력을 소모하게 되었다. 데이터센 터 안에 수만 대의 에어컨이 돌아가는 셈이니, 상상해보시라. 오죽했으 면 H100의 연간 소비전력량이 소규모 국가와 맞먹는다느니, '엔비디아 의 AI는 전기료를 먹고 자란다'는 말이 나돌까. 아닌 게 아니라 엔비디아 의 2024년 H100 판매량이 200만 개로 전망되므로, 그 연간 전력 소비는 리투아니아나 과테말라의 연간 소비전력량과 비슷하다.

이 같은 전력 과소비의 주범이 엔비디아 AI 가속기의 '순차적인' 데 이터 저장과 이로 인한 작업 처리 지연, 즉 '병목현상'임이 밝혀지자, 삼성전자도 해결책 찾기에 나섰다. 차세대 메모리 PIM 개발과정에서 메모 리와 시스템반도체 사이 구조를 최적화시키는 경험을 쌓아 데이터 병목 현상을 풀어낼 최적의 설계도를 그리게 되었으며, 마침내 효율적인 AI 가속기를 직접 만들 수 있다는 희망을 찾아낸다. 그리고 거기에 '마하1' 이란 이름을 붙였다. 쉽게 말해서 메모리 내부에 각각 작은 AI 엔진을 장 착하고 데이터의 '병렬 처리'를 극대화해 성능을 높이고 전력 소모를 낮 춘 것이다. 그리고 이를 실증해보기 위해 AI 데이터 처리 경험이 풍부한 소프트웨어 기업 네이버와 손을 잡게 된다. 네이버는 '파운데이션 모델' 을 보유하고 동시에 AI 수퍼컴퓨터와 데이터센터를 운영하는 세계 몇 안 되는 기업이다. 마침 네이버는 사용 중인 엔비디아 GPU 기반 AI 칩이 너무 비싸고 전력 소모량이 커 고민하던 중이었다. 마하-1의 활용 테스 트에서 이미 네이버의 초거대 AI 모델 하이퍼클로바X를 구동하는 데 성 공한 상태다. 이렇게 국내 하드웨어와 소프트웨어 1위가 의기투합해 한 국판 '엔비디아 전선'이 형성된 것이다.

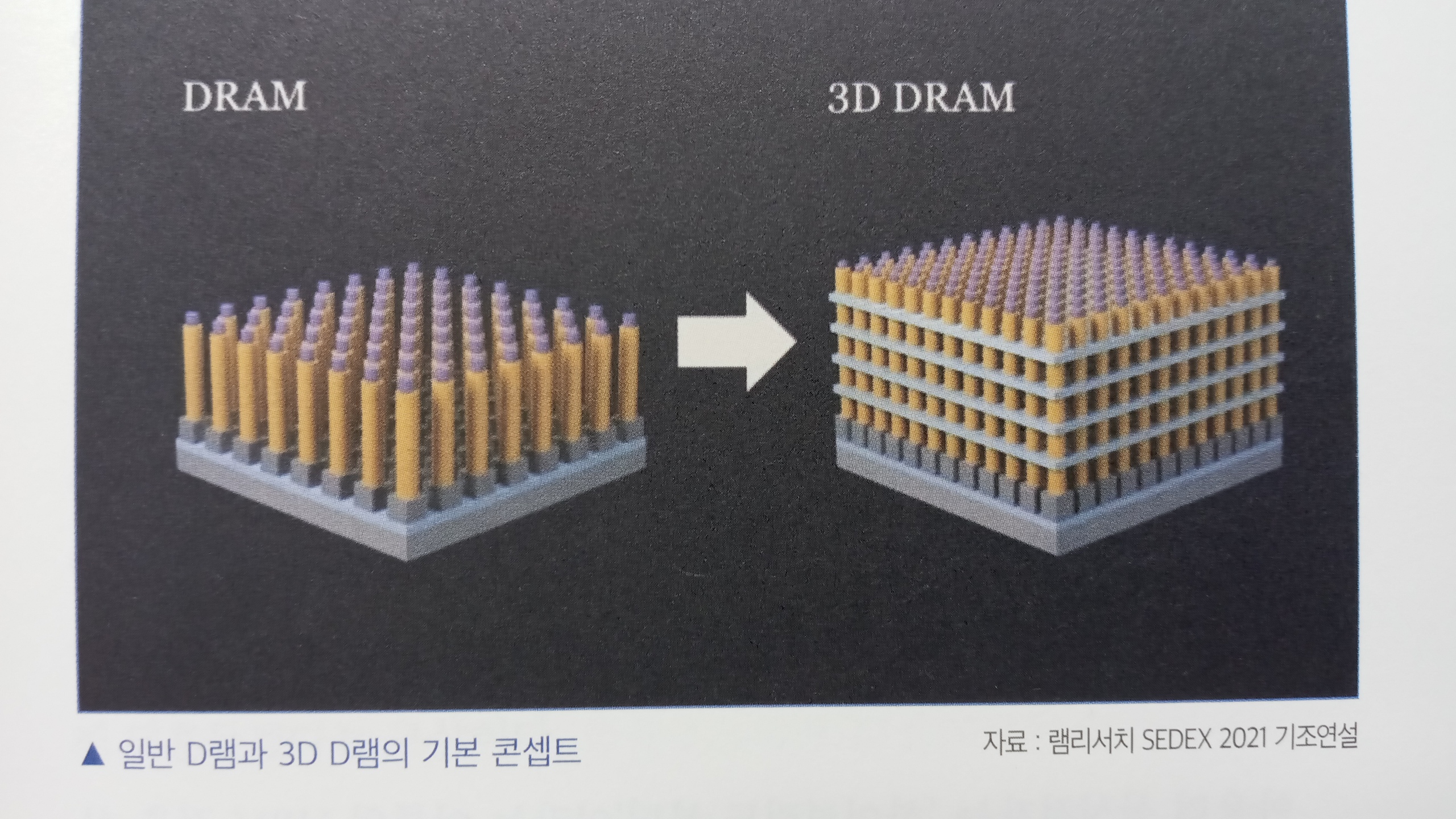

- 삼성전자는 세계 최초로 2025년 '꿈의 메모리'로 불리는 3차원(3D) D램을 공개하기 위해 분주하다. 기존의 D램은 기판에 최대 620억 개에 달 하는 셀(데이터 저장공간)을 수평으로 빡빡하게 배치해 전류 간섭 현상을 피 하기 어렵다. 하지만 3D D램은 셀을 수직으로 쌓아 단위 면적당 용량을 3배 키우고 간섭 현상도 줄인 제품이다. HBM은 D램을 여러 개 쌓아 용 량을 늘리지만, 3D D램은 내부에 있는 셀을 수직으로 쌓은 한 개의 D램 이라는 점에서 대조된다. '칩 크기는 줄이고 데이터 처리용량은 늘려야 하는' D램 개발자의 영원한 과제가 더욱 중요해진 AI 시대엔 3D D램이 게임 체인저가 될 수 있다.

- 3D D램은 스마트폰, 노트북처럼 작은 기기에 먼저 적용될 것 같지 만, 도로에서 수집한 수많은 데이터를 처리해야 하는 자율주행에 활용 될 가능성도 크다. 3D D램 시장은 2030년께 1,000억 달러(135조원) 규모에 이를 것이란 관측이 나온다. 4년 전부터 3D D램 연구를 시작한 마이크 론을 비롯해 경쟁사들도 3D D램 개발에 열중이지만 아직 로드맵은 공 개하지 못했다. SK하이닉스는 여러 기회에 3D D램 콘셉트만 공개한 정 도다. 중국의 경우, 메모리 1위 창신메모리(长存 CXMT)와 몇몇 업체들 도 3D D램 개발에 속도를 내며, 삼성전자를 추격할 기회를 호시탐탐 노 리고 있다.

- '아차' 하는 순간 HBM 시장에서 SK하이닉스에 주도권을 빼앗기고 2023년 매출에서 TSMC, 인텔, 엔비디아에 밀려버린 삼성전자는 어디서 반격의 실마리를 찾을까? 반도체 산업 전반의 불황도 있었지만, 삼성이 사업을 잘못한 측면도 있었다는 업계의 평가 속에서, 삼성의 전략은 두 방향으로 펼쳐진다. HBM이 필요 없는 신개념 AI 가속기를 출시하는 게 그 하나, 그리고 동시에 HBM 시장에서도 치열하게 싸우겠다는 게 또다 른 하나다. 병행 전략, 즉, 투-트랙(two-track) 접근법으로 2년~3년 내 반도 체 세계 1위를 탈환하겠다는 각오다. 그리고 여기에 2030년까지 20조원 이 투입될 예정이다.

- NPU(Neural Processing Unit; 신경망 처리장치)는 AI 연산을 위해 인간의 뇌신 경망을 모방한 시스템반도체로, 정보처리 방식이 사람의 뇌(신경망)와 비 슷하다. CPU나 GPU보다 범용성은 떨어지지만, AI의 양대 축인 '학습' 과 '추론' 중 추론에 특화돼 있다. 특히 추론(서비스) 영역에서는 GPU보다 더 효율적이다. NPU는 주로 전자기기용 시스템 온 칩(SoC)에 장착돼 외 국어 자동 번역, 콘텐트 화질 업그레이드 등을 담당한다. 미래의 NPU는 아예 프로그래밍이 가능한 반도체(FPGA)라든가 주문형 반도체(ASIC) 혹 은 뇌 신경세포와 연결고리 구조를 닮은 뉴로모픽(Neuromorphic) 등의 형태 로 발전할 것이라 한다.

온디바이스 AI를 장착한 기기는 클라우드 연결 없이 자체적으로 AI 서비스를 구현하는데, 이 기능을 수행하는 것이 바로 NPU다. 온디바이 스 AI와 NPU는 한 몸처럼 같이 움직인다는 얘기다. 최근 온디바이스 AI 기능을 장착한 스마트폰, TV, 노트북, PC 등이 잇달아 나오면서 NPU는 덩달아 '귀한 몸'이 되고 있다. 시장조사업체 가트너는 NPU 시장 규모가 2022년의 326억 달러(43조 원)에서 2030년 1,170억 달러(약 154조 원)로 커진 다고 전망하는데, 이는 챗GPT 혁명이 불러온 변화의 하나다.

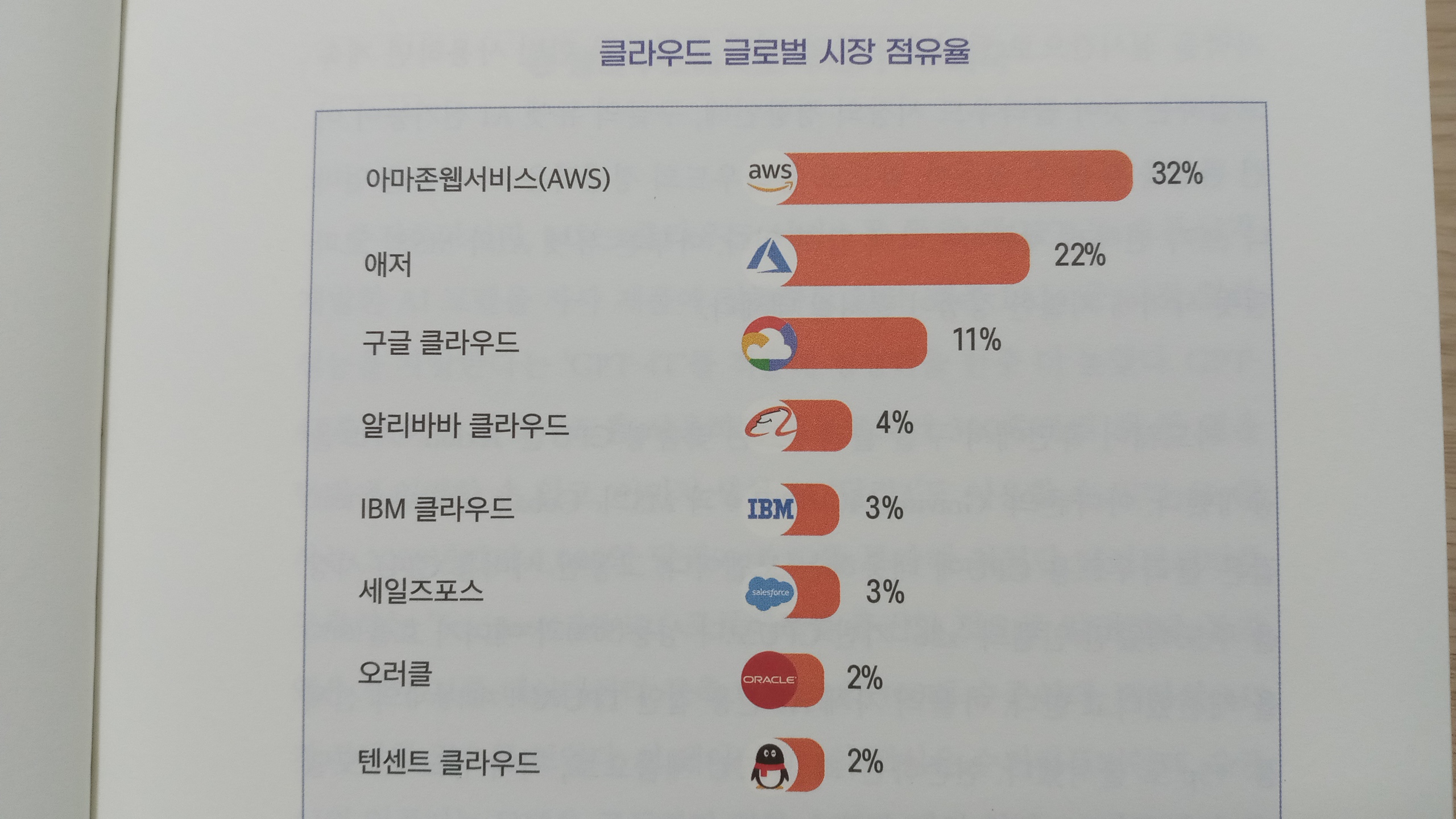

- 생성 AI 기술이 본격 도입되면서 빅 테크들은 AI 클라우드 플랫폼 경쟁력을 어떤 식으로 끌어올릴까? 다수의 경쟁력 있는 LLM과 생성 AI 소프트웨어를 한곳에 모아 기업 고객이 쉽고 편하게 활용할 수 있도록 하는 게 기본 방식이다. 고객의 생산성 향상에 요긴하다면, 경쟁사 제품 이라도 무슨 상관인가. 누가 만든 것이든 가능한 한 많은 AI 설루션을 적 극적으로 도입해 우리의 클라우드 경쟁력을 강화하면 되지 않는가. 수백 개의 생성 AI를 확보해 레고처럼 조립하도록 돕는 'AI 믹스' 시대를 열면 된다. AI 모델로 수익을 올리는 게 아니라, 클라우드 서비스로써 돈을 벌 면 되지 않겠는가. 그래서 MS에 이어 구글도 개방형 협업 툴이란 전략을 채택하면서 클라우드 시장을 달구고 있다. AI 업계는 최근 이들의 클라 우드 서비스를 특징짓는 3대 요소로 (1) 오픈소스 (개방형) (2) 원클릭(손쉬운 활용) (3) 데이터 보안을 꼽기도 했다. 여기서 우리는 앞으로 AI 시대를 받침할 클라우드 서비스의 공통된 흐름 혹은 트렌드를 짐작할 수 있다.

- AI와 클라우드는 국가안보 문제와도 단단히 묶여 있다. AI를 국가 전략기술로 봐야 할 가장 큰 이유다. 세액공제 등의 방법으로 국내 기업· 기술을 키우지 않고 외국 서비스에 의존하다가는 데이터 주권을 빼앗길 까 봐 우려하는 이유이기도 하다. 그래서 최근 이른바 'Sovereign AI(소버 린 AI)'가 쟁점으로 부상한 게 아닐까. AI와 클라우드를 위한 데이터 저장 을 역내에서 제어하고 국가안보와 개인정보보호의 통제권을 확보하자 는 얘기다. 우리 정부도 AI 선도국들처럼 국가 차원에서 국내 AI·클라우 드 기술력을 확보해야 한다. 클라우드 전환은 피할 수 없는 추세이므로, 다른 민간 네트워크와 분리된 공공기관용 클라우드 권역을 마련해야 한 다. 국내에서는 NHN클라우드가 국가 AI 데이터센터를 조성하는 등 인 프라 분야에 강점이 있다.

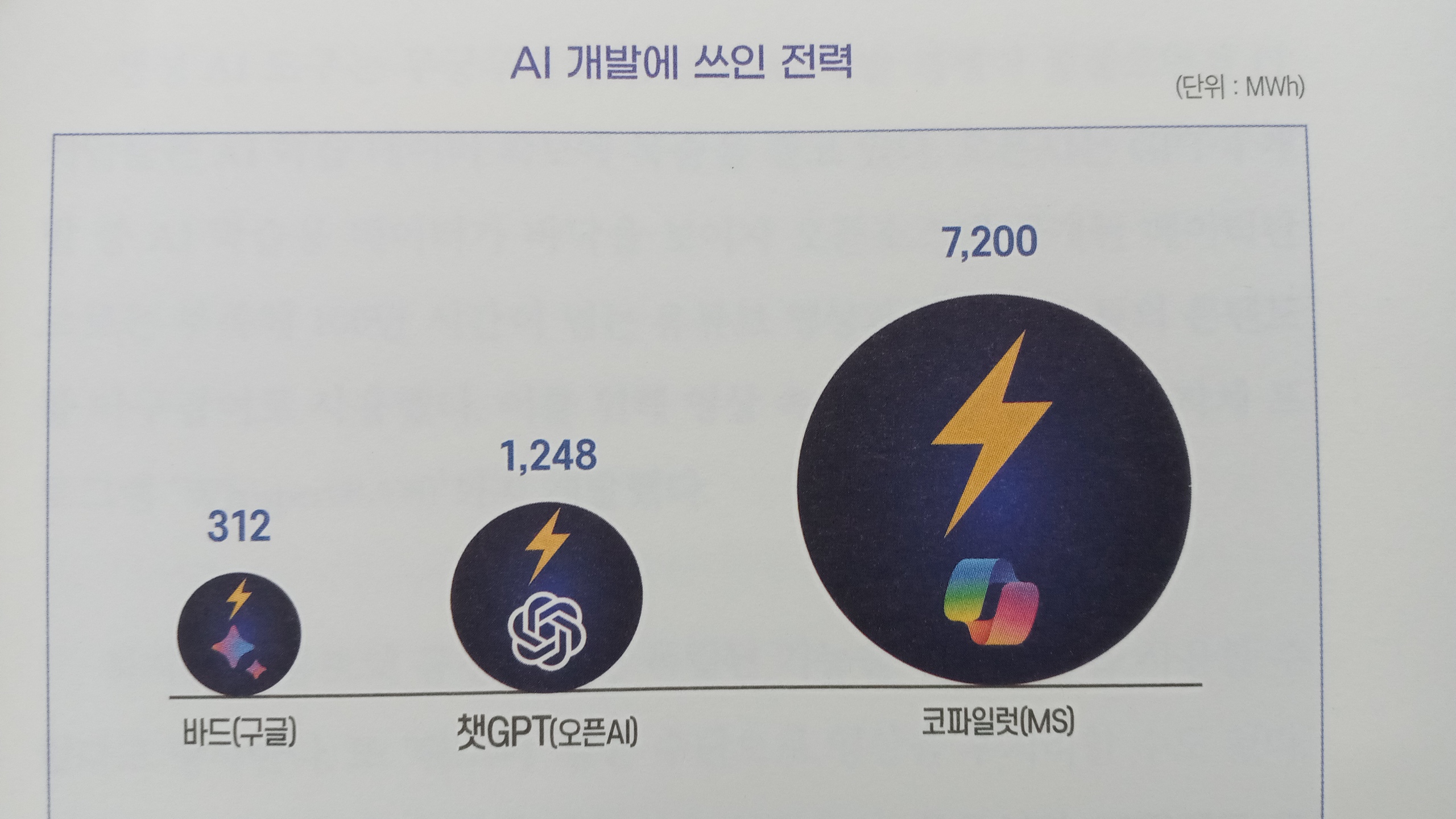

- 가령 MS의 AI '코파일럿' 개발에 사용된 약 7,200MWh의 전력은 웬 만한 도시가 사용하고도 남는 화력발전소 2곳의 발전량에 해당한다. 뉴 욕타임스는 4년 안에 AI가 연간 무려 130TWh(테라와트시) 이상의 전력을 쓸 것으로 예측한다. 네덜란드나 스웨덴 같은 국가가 1년 사용하는 전력 량과 비슷하다. 여기에는 AI 학습과 서비스 제공만 고려되었을 뿐, 소비 자들의 AI 기기 사용으로 늘어나는 수요는 포함되지도 않았다. 국제에 너지기구가 예측해본 2026년 상황을 보기로 하자. 그땐 전 세계 데이터 센터가 소모하는 전력량이 일본 전체에서 한 해 동안 사용하는 전기량 (939TWh)과 같은 수준일 거라고 했다. 인구 1억2,000만 명의 경제 대국이 1년간 쓸 전력이라니, 무슨 비유가 더 필요하겠는가.

'IT' 카테고리의 다른 글

| AI 인간지능의 시대 (0) | 2024.08.18 |

|---|---|

| 데이터로 사고하고 데이터로 리드하라 (0) | 2024.08.02 |

| 크립토사피엔스와 변화하는 세상의 질서 (3) | 2024.01.31 |

| 챗 GPT전쟁 (1) | 2023.12.26 |

| 챗 GPT 거대한 전환 (1) | 2023.12.24 |